通过共同学习对齐和翻译进行神经网络机器翻译

神经网络机器翻译是最近提出的机器翻译方法。 与传统的统计机器翻译不同,神经网络机器翻译的目标是建立一个单一的神经网络,它可以联合调优以最大化翻译性能。 最近提出的神经网络机器翻译模型通常属于编码器-解码器系列,它们将源语句编码成一个固定长度的向量,然后解码器根据这个向量生成翻译。 在本文中,我们推测使用固定长度的向量是提高这种基本编码器-解码器架构性能的瓶颈,并提出一种扩展,通过允许模型自动(软)搜索源句中与预测目标单词相关的部分,而不用必须明确地将这些部分形成为一个固定的部分。 通过这种新方法,在英语到法语翻译的任务上,我们达到与现有最先进的基于短语的系统相当的翻译性能。 此外,定性分析显示,模型发现的(软)对齐符合与我们的直觉。

1 简介

神经网络机器翻译是一种新兴的机器翻译方法,最近由Kalchbrenner and Blunsom (2013)、Sutskever et al. (2014)和Cho et al. (2014b)提出。 传统的基于短语的翻译系统(参见Koehn et al., 2003)由许多小的子组件组成,这些组件独立调优,而神经网络机器翻译尝试构建和训练一个单一的大型神经网络,它读取句子并输出正确的翻译。

大多数提出的神经网络机器翻译模型属于编码器-解码器系列(Sutskever et al., 2014; Cho et al., 2014a),每种语言一个编码器和解码器,或者将特定于某种语言的编码器应用到每个句子,然后将它们的输出进行比较(Hermann and Blunsom, 2014)。 编码器神经网络读取并编码源语句成一个固定长度的向量。 然后解码器从这个编码向量输出翻译。 整个编码器-解码器系统,由针对一对语言的编码器和解码器组成,被联合训练以最大化给定源句子的正确翻译的概率。

这种编码器-解码器方法的潜在问题是神经网络需要能够将源语句的所有必要信息压缩到固定长度向量中。 这可能使得神经网络难以处理长句子,特别是那些比训练语料库中的句子更长的句子。 Cho et al. 2014b表明,基本编码器-解码器的性能确实随着输入句子的长度增加而迅速恶化。

为了解决这个问题,我们引入编码器-解码器模型的一种扩展,它联合学习对齐和翻译。 所提出的模型在翻译中每次生成单词时,它(软)搜索源语句中信息最相关的一组位置。 然后,模型基于与这些源位置相关联的上下文向量和先前产生的所有目标单词来预测新的目标单词。

该方法与基本编码器-解码器的最重要的区别特征在于,它不试图将整个输入语句编码为单个固定长度向量。 相反,它将输入句子编码为向量序列,并且在解码翻译时自适应地选择这些向量的子集。 这使得神经翻译模型不必将源语句的所有信息压缩成固定长度的向量,而不管其长度如何。 我们显示这允许一个模型更好地处理长句子。

在这篇文章中,我们表明提出的这个联合学习对齐和翻译的方法相对基本的编码器-解码器方法显著提高了翻译性能。 这种改善在较长的句子中更为明显,但任何长度的句子都可以观察到。 在英语到法语翻译的任务中,提出的这个方法利用单个模型达到了与传统的基于短语的系统相当或接近的翻译性能。 此外,定性分析显示,提出的这个模型找到源语句和相应的目标语句之间的语言学上似乎合理的(软)对齐。

2 背景:神经网络机器翻译

从概率的角度来看,翻译相当于找到一个目标句子y,它使给定句子x的条件下y的条件概率argmaxyp(y∣x)最大化。 在神经网络机器翻译中,利用并行训练语料库,我们拟合一个参数化模型来最大化句子对的条件概率。 一旦通过翻译模型学习了条件分布,给定源句子,可以通过搜索使条件概率最大化的句子来生成相应的翻译。

最近,一些论文提出使用神经网络来直接学习这种条件分布(参见Kalchbrenner and Blunsom, 2013; Cho et al., 2014a; Sutskever et al., 2014; Cho et al., 2014b; Forcada and Ñeco, 1997)。 这种神经网络机器翻译方法通常包括两个组成部分,第一个组成部分编码源语句x,第二个组成部分解码到目标语句y。 例如,(Cho et al., 2014a)和(Sutskever et al., 2014)使用两个循环神经网络(RNN)来将可变长度源语句编码为固定长度向量并将向量解码为一个可变长度的目标句子。

尽管是一个相当新的方法,神经网络机器翻译已经显示了有希望的结果。 Sutskever et al. 2014报道,在一个英语到法语的翻译任务上,基于具有长短期记忆(LSTM)单元的RNN的神经网络机器翻译达到了接近于传统的基于短语的机器翻译系统的最先进的性能1。为现有翻译系统添加神经网络元素,例如为了对短语表中的短语对进行评分(Cho et al., 2014a)或重新排列候选翻译(Sutskever et al., 2014,已经超越以前最先进的性能水平。

2.1 RNN 编码器-解码器

这里,我们简要描述底层框架,称为RNN编码器-解码器,由Cho et al. 2014a等和Sutskever et al. 2014提出,并在它之上我们建立一个新的架构,学习同时对齐和翻译。

在编码器-解码器框架中,编码器读取输入序列的向量x =  为一个向量c。2 最常见的方法是使用一个RNN,使得

为一个向量c。2 最常见的方法是使用一个RNN,使得

ht = f | (1) |

c = q , , |

= hT。

= hT。

通常训练解码器来预测给定上下文向量c和所有先前预测的单词 的下一个单词yt ′。 换句话说,解码器通过将联合概率分解为有序条件概率定义翻译y的一个概率:

的下一个单词yt ′。 换句话说,解码器通过将联合概率分解为有序条件概率定义翻译y的一个概率:

p(y) = ∏

t=1Tp(y

t∣ ,c), ,c), | (2) |

. 利用RNN,每个条件概率建模为

. 利用RNN,每个条件概率建模为

p(yt ∣ ,c) = g(yt-1, st ,c), ,c) = g(yt-1, st ,c), | (3) |

3 学习对齐和翻译

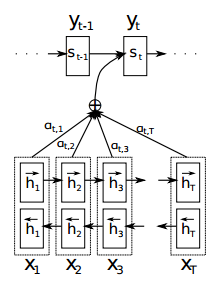

在这一节,我们提出一种用于神经网络机器翻译的新颖体系结构。 新架构包括一个双向RNN作为编码器(3.2节)和一个在解码翻译期间模拟搜索源语句的解码器(3.1节)。

3.1 解码器:概述

在一个新的模型架构中,我们定义等式(2)中的每个条件概率为:

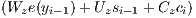

| p(yi |y1,…,yi-1,x) = g(yi-1,si ,ci ), | (4) |

应该注意,与已有的编码器-解码器方法不同(参见等式(2)),这里的每个目标单词yi是不同的上下文向量ci上的条件概率。

上下文向量ci依赖于输入序列通过编码器映射后的注解 序列(h1, ,hTx)。 每个注解hi包含整个输入序列的信息,并重点关注输入序列第i个单词的邻近部分。 在下一节我们详细解释如何计算注解。

,hTx)。 每个注解hi包含整个输入序列的信息,并重点关注输入序列第i个单词的邻近部分。 在下一节我们详细解释如何计算注解。

上下文向量ci 计算成这些注解hi 的加权和:

| ci = ∑ j=1Tx αijhj. | (5) |

αij =  , , | (6) |

是一个对齐模型,它评分位置j 周围的输入和位置i 的输出匹配程度。 这个分数基于RNN隐藏状态 si-1(在生成yi之前,等式(4))和输入序列第j个注解hj。

我们将对齐模型a 参数化为一个前馈神经网络,它与所提出的系统的所有其它组成部分联合训练。 注意,与传统的机器翻译不同,对齐不被认为是潜在变量。 相反,这个对齐模型直接计算软对齐,这允许通过反向传播成本函数的梯度。 该梯度可以用于联合训练对齐模型以及整个翻译模型。

我们可以将注解加权和的方法理解为计算期望注解,其中期望就是可能的对齐。 令αij 是目标词yi 与源词xj 对齐或从源词翻译出来的概率。 那么,第i 个上下文向量ci 是所有具有概率αij 的注解的期望注解。

概率αij 或其相关联的能量eij 反映了关于先前隐藏状态si-1 的注解hj在决定下一个状态si 并生成yi 时的重要性。 直观地,这实现了解码器中的注意机制。 解码器决定需要注意的源语句中部分。 通过让解码器有一个注意机制,我们解决了编码器必须将源语句中的所有信息编码成固定长度向量的负担。 利用这种新方法,信息可以散布到注解的序列中,其可以由解码器相应地选择性地检索。

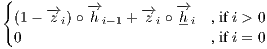

3.2 编码器:用于注解序列的双向RNN

通常的RNN,如公式(1),以从第一个符号x1 到最后一个符号xTx 的顺序读取输入序列x。 然而,在提出的这个方案中,我们希望每个单词的注解不仅能够总结前面的单词,而且还要总结后面单词。 因此,我们提出使用最近在语音识别中成功使用的双向RNN(Schuster and Paliwal, 1997)(参见Graves et al., 2013)。

双向RNN由前向RNN和反向RNN组成。 前向 按原始顺序读取输入序列(从x1 到xTx)并计算一个前向隐藏状态 序列(

按原始顺序读取输入序列(从x1 到xTx)并计算一个前向隐藏状态 序列( 1,

1, ,

, Tx)。 后向RNN

Tx)。 后向RNN 按相反的顺序读取序列(从xTx 到x1),得到一个反向隐藏状态 的序列(

按相反的顺序读取序列(从xTx 到x1),得到一个反向隐藏状态 的序列( 1,

1, ,

, Tx)。

我们得到将前向隐藏状态

Tx)。

我们得到将前向隐藏状态 j 和后向隐藏状态

j 和后向隐藏状态 j 连接起来,每个单词xj 的注解,即hj =

j 连接起来,每个单词xj 的注解,即hj =  ⊤。 通过这种方法,注解hj 同时包含前面的单词和后面的单词的摘要。 因为RNN倾向于更好地表示最近的输入,注解hj 将集中于xj 周围的单词。 这个注解序列将用于后面的解码器和对齐模型来计算上下文向量(等式 (5)-(6))。

该的模型的图解参见图1。

⊤。 通过这种方法,注解hj 同时包含前面的单词和后面的单词的摘要。 因为RNN倾向于更好地表示最近的输入,注解hj 将集中于xj 周围的单词。 这个注解序列将用于后面的解码器和对齐模型来计算上下文向量(等式 (5)-(6))。

该的模型的图解参见图1。

4 实验的设置

我们在英语-法语的任务上评估该提出的方法。 我们使用ACL WMT’14提供的平行双语语料库。3 作为比较,我们还报告了最近由Cho et al. 2014a提出的RNN编码器-解码器的性能。 两个模型使用相同的训练过程和数据集。4

4.1 数据集

WMT'14包含以下英法平行语料库:Europarl(61M个单词)、新闻评论(5.5M)、联合国(421M)和两个爬取得语料库,分别为90M和272.5M个单词,共计8.5亿个单词。 依据Cho et al. 2014a中描述的过程,我们使用Axelrod et al. 2011中提到的选择方法减少组合后的语料库到348M个单词。5 我们没有使用任何单语言的语料库,虽然可以使用一个非常大的单语言语料库来预训练一个编码器。 我们合并news-test-2012和news-test-2013来生成一个开发(验证)集,并在WMT'14的测试集(news-test-2014)上对模型进行评估,该测试集由3003个句子组成且不在训练数据中。

在通常的单词切分之后6,我们使用每种语言中30,000个最常用词汇的列表来训练我们的模型。 没有包括在列表中的任何单词都被映射到一个特殊的标记(![[U NK]](search45x.png) )。 我们没有对数据应用任何其他特殊的预处理,例如变成小写或提前词根。

)。 我们没有对数据应用任何其他特殊的预处理,例如变成小写或提前词根。

4.2 模型

我们训练两种类型的模型。 第一个是RNN编码器—解码器(RNNencdec, Cho et al., 2014a),另一个是这里所提出的模型,我们称之为RNNsearch。 我们对每个模型进行两次训练:首先使用最长长度为30个单词的句子(RNNencdec-30,RNNsearch-30),然后使用最长长度为50个单词的句子(RNNencdec-50,RNNsearch-50)。

RNNencdec的编码器和解码器各有1000个隐藏单元。7 RNNsearch的编码器由前向和后向循环神经网络(RNN)组成,每个网络有1000个隐藏单元。 它的解码器有1000个隐藏单元。 对于这两种情况,我们都使用具有单个最大值(Goodfellow et al., 2013)隐层的多层网络来计算每个目标词的条件概率(Pascanu et al., 2014)。

我们使用小批次随机梯度下降(SGD)算法和Adadelta(Zeiler, 2012)一起训练每个模型。 每个SGD更新方向使用80个句子的minibatch进行计算。 每个模型我们训练了大约5天。

模型训练好之后,我们使用beam search来找到近似最大化条件概率的翻译(参见Graves, 2012; Boulanger-Lewandowski et al., 2013)。 Sutskever et al. 2014使用这种方法从他们的神经网络机器翻译模型生成翻译。

有关实验中使用的模型的架构和训练过程的更多详细信息,请参见附录A和B。

5 结果

5.1 定量结果

| 模型 | 所有语句 | 没有UNK的语句 ∘ |

| RNNencdec-30 | 13.93 | 24.19 |

| RNNsearch-30 | 21.50 | 31.44 |

| RNNencdec-50 | 17.82 | 26.71 |

| RNNsearch-50 | 26.75 | 34.16 |

| RNNsearch-50 ⋆ | 28.45 | 36.15 |

| Moses | 33.30 | 35.63 |

在表1中,我们用BLEU分数列出测量的翻译的性能。 从表中可以清楚地看出,在所有情况下,我们所提出的RNNsearch都优于传统的RNNencdec。 更重要的是,当仅考虑由已知词构成的句子时,RNNsearch的性能与传统的基于短语的翻译系统(Moses)的性能一样好。 考虑到除了用于训练RNNsearch和RNNencdec的平行语料之外,Moses 还使用单独的单语语料(418个单词),这是一个重大成就。

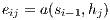

我们提出的方法背后的动机之一是解决在基本的编码器-解码器方法中使用固定长度的上下文向量。 我们推测,这种限制可能会使基本的编码器-解码器方法的表现不佳,特别是较长的句子。 在图2中,我们看到随着句子长度的增加,RNNencdec的性能急剧下降。 另一方面,RNNsearch-30和RNNsearch-50对句子的长度都更加健壮。 特别是RNNsearch-50,即使长度为50或以上的句子也没有表现出性能下降。 RNNsearch-30甚至优于RNNencdec-50(参见表1),这一事实进一步证实了所提出的模型相对于基本编码器-解码器的优越性。

5.2 定性分析

5.2.1 对齐

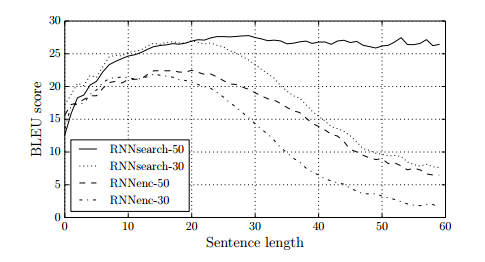

我们所提出的方法提供了一种直观的方式来检查生成的翻译中的单词与源句子中的单词之间的(软)对齐。 通过从等式(6)中可视化注解权重αij来实现,如图3所示。 图中每个矩阵的每一行表示与注解相关的权重。 由此我们看到源句子中的哪些位置在生成目标词时被认为更重要。

从图3中的对齐中我们可以看到,英语和法语之间的单词对齐在很大程度上没有变化。 我们看到每个矩阵的对角线上有很强的权重。 但是,我们也观察到了一些不是很重要的、有变化的对齐。 形容词和名词通常在法语和英语之间以不同的顺序排列,我们在图3(a)中看到一个例子。 从这个图中我们可以看出该模型正确地将一个短语[European Economic Area]翻译成[zone économique européen]。 RNNsearch能够将[zone]与[Area]正确对齐,跳过两个单词([European]和[Economic]),然后再回查看一个单词以完成整个短语[zone économique européenne]。

从图3(d)可以看出,软对齐的强度与硬对齐相反。 考虑翻译成[l’ homme]的源语词[the man]。 任何硬对齐将把[the]映射到[l'],把[man]映射到[homme]。 这对翻译没有帮助,因为人们必须考虑[the]之后的单词来确定它是否应该翻译成[le]、[la]、[les]还是[l']。 我们的软对齐通过让模型查看[the]和[man]来自然解决这个问题,并且在这个例子中,我们看到模型能够正确地将[the]翻译为[l']。 我们在图3所示的所有情形中观察到类似的行为。 软对齐的另一个好处是,它自然处理不同长度的源和目标短语,而不需要反映直观的方式将某些词映射到空白([NULL])或从空白([NULL])映射过来(参见Koehn, 2010的第4章和第5章)。

5.2.2 长的语句

从图2清楚可见,我们所提出的模型(RNNsearch)在翻译长句时比传统模型(RNNencdec)好得多。 这可能是由于RNNsearch不需要将长句子完美地编码为固定长度的矢量,而只需要精确地编码输入句子中围绕特定单词的部分。

作为一个例子,从测试集中考虑这个源语句:

An admitting privilege is the right of a doctor to admit a patient to a hospital or a medical centre to carry out a diagnosis or a procedure, based on his status as a health care worker at a hospital.

RNNencdec-50将这句话翻译成:

Un privilège d’admission est le droit d’un médecin de reconnaître un patient à l’hôpital ou un centre médical d’un diagnostic ou de prendre un diagnostic en fonction de son état de santé.

RNNencdec-50正确翻译源句子直到[a medical center]。 然而,从那里开始(下划线),它偏离了源句的原意。 例如,它将原始句子中的[based on his status as a health care worker at a hospital]替换成了[en fonction de son état de santé](“based on his state of health”)。

另一方面,RNNsearch-50生成了以下正确的翻译,保留了输入句子的全部含义而不遗漏任何细节:

Un privilège d’admission est le droit d’un médecin d’admettre un patient àun hôpital ou un centre médical pour effectuer un diagnostic ou une procédure, selon son statut de travailleur DES soins de santé à l’hôpital.

让我们考虑测试集中的另一句话:

This kind of experience is part of Disney’s efforts to ”extend the lifetime of its series and build new relationships with audiences via digital platforms that are becoming ever more important,” he added.

RNNencdec-50的翻译是

Ce type d’expérience fait partie des initiatives du Disney pour ”prolonger la durée de vie de ses nouvelles et de développer des liens avec les lecteurs numériques qui deviennent plus complexes.

和前面的例子一样,RNNencdec在生成大约30个单词后(见下划线短语)开始偏离源句子的实际含义。 在那之后,翻译质量会下降,并且会出现基本的错误,例如缺乏结束的引号。

再次,RNNsearch-50能够正确翻译这个长句子:

Ce genre d’expérience fait partie des efforts de Disney pour ”prolonger la durée de vie de ses séries et créer de nouvelles relations avec des publics via DES plateformes numériques de plus en plus importantes” A-T-IL ajouté.

结合已经提供的定量结果,这些定性观察证实了我们的假设,即RNNsearch体系结构能够比标准RNNencdec模型更可靠地翻译长句子。

在附录C中,我们提供了由RNNencdec-50、RNNsearch-50和Google翻译生成的长源句子的一些样本翻译以及参考翻译。

6 相关的工作

6.1 学习对齐

Graves 2013最近在手写合成的任务中提出了一种类似的将输出符号与输入符号对齐的方法。 手写合成是要求模型生成给定字符序列的手写的任务。 在他的工作中,他使用高斯核的混合来计算注解的权重,其中每个核的位置、宽度和混合系数是从对齐模型预测的。 更具体地说,他的对齐被限制为预测位置,增加了位置的变化。

与我们的方法的主要区别在于,在(Graves, 2013)中,注解的权重模式仅向一个方向移动。 在机器翻译的情况下,这是一个严重的限制,因为经常需要(长距离)重新排序来生成语法正确的翻译(例如,英语到德语)。

另一方面,我们的方法需要计算翻译中每个单词的源句子中每个单词的注解权重。 这个缺点对于大多数输入和输出句子只有15-40个单词的翻译任务并不严重。 但是,这可能会限制所提议方案对其他任务的适用性。

6.2 用于机器翻译的神经网络

自从Bengio et al. 2003引入了一种神经概率语言模型,该模型使用神经网络对给定固定数量的前述单词的单词的条件概率进行建模,神经网络已广泛用于机器翻译。 然而,神经网络的作用很大程度上局限于简单地向现有统计机器翻译系统提供单一特征或重新排列现有系统提供的候选翻译列表。

例如,Schwenk 2012提出使用前馈神经网络来计算源词组和目标词组对的分值,并将分值用作基于短语的统计机器翻译系统中的一个附加特征。 最近,Kalchbrenner and Blunsom 2013和Devlin et al. 2014报道了神经网络作为现有翻译系统的一个子组件的成功使用。 传统上,为目标侧语言模型训练的神经网络已被用于重新排列或重新排列候选翻译列表(参见Schwenk et al., 2006)。

尽管上述方法被证明可以提高翻译的性能,但是我们更关心的是设计一个基于神经网络的全新翻译系统的更宏大的目标。 因此,我们在本文中考虑的神经机器翻译方法与这些早期的作品是完全不同的。 我们的模型不是使用神经网络作为现有系统的一部分,而是直接运用原始语句生成翻译。

7 结论

神经网络机器翻译的传统方法称为编码器—解码器方法,将整个输入句子编码成固定长度的矢量,从中翻译将被解码。 根据 Cho et al. 2014b和Pouget-Abadie et al. 2014报道的最近的一项实证研究,我们推测使用固定长度的上下文向量对于翻译长句子是有问题的。

在本文中,我们提出了一种解决此问题的新颖架构。 当生成每个目标词时,我们扩展了基本的编码器—解码器,方法是对模型(软)搜索一组输入词或由编码器计算的注释。 这使得模型不必将整个源语句编码为固定长度的向量,并且还可以让模型只关注与生成下一个目标词相关的信息。 这对神经网络机器翻译系统对较长句子产生良好结果的能力具有重大的积极影响。 与传统机器翻译系统不同,包括对齐机制在内的所有翻译系统片段都被共同训练,以产生正确翻译的更好的对数概率。

我们测试了这个被称为RNNsearch的模型,用于英语到法语翻译的任务。 实验表明,无论句子长度如何,所提出的RNNsearch都显着优于传统的编码器-解码器模型(RNNencdec),并且它对源句子的长度更加稳健。 从我们调查RNNsearch产生的(软)对齐的定性分析中,我们得出结论,该模型可以正确地将每个目标词与源句子中的相关词或其注释对齐,因为它产生了正确的翻译。

也许更重要的是,所提出的方法实现了与现有的基于短语的统计机器翻译相当的翻译性能。 考虑到提出的体系结构或整个神经机器翻译系列仅在今年才提出,这是一个惊人的结果。 我们相信这里提出的架构是朝着更好的机器翻译和更好地理解自然语言迈出的有希望的一步。

未来面临的挑战之一是更好地处理未知的或稀有的词汇。 这将是模型被更广泛地使用和匹配当前最先进的机器翻译系统在所有情况下的性能所必需的。

致谢

作者要感谢Theano的开发人员(Bergstra et al., 2010; Bastien et al., 2012)。 我们感谢以下机构对研究资助和计算的支持:NSERC, Calcul Québec, Compute Canada, the Canada Research Chairs and CIFAR。 Bahdanau感谢Planet Intelligent Systems GmbH的支持。 我们也感谢Felix Hill,Bart vanMerriénboer,Jean Pouget-Abadie,Coline Devin和Tae-Ho Kim。

参考文献

Axelrod, A., He, X., and Gao, J. (2011). Domain adaptation via pseudo in-domain data selection. In Proceedings of the ACL Conference on Empirical Methods in Natural Language Processing (EMNLP), pages 355-362. Association for Computational Linguistics.

Bastien, F., Lamblin, P., Pascanu, R., Bergstra, J., Goodfellow, I. J., Bergeron, A., Bouchard, N., and Bengio, Y. (2012). Theano: new features and speed improvements. Deep Learning and Unsupervised Feature Learning NIPS 2012 Workshop.

Bengio, Y., Simard, P., and Frasconi, P. (1994). Learning long-term dependencies with gradient descent is difficult. IEEE Transactions on Neural Networks, 5(2), 157-166.

Bengio, Y., Ducharme, R., Vincent, P., and Janvin, C. (2003). A neural probabilistic language model. J. Mach. Learn. Res., 3, 1137-1155.

Bergstra, J., Breuleux, O., Bastien, F., Lamblin, P., Pascanu, R., Desjardins, G., Turian, J., Warde-Farley, D., and Bengio, Y. (2010). Theano: a CPU and GPU math expression compiler. In Proceedings of the Python for Scientific Computing Conference (SciPy). Oral Presentation.

Boulanger-Lewandowski, N., Bengio, Y., and Vincent, P. (2013). Audio chord recognition with recurrent neural networks. In ISMIR.

Cho, K., van Merrienboer, B., Gulcehre, C., Bougares, F., Schwenk, H., and Bengio, Y. (2014a). Learning phrase representations using RNN encoder-decoder for statistical machine translation. In Proceedings of the Empiricial Methods in Natural Language Processing (EMNLP 2014). to appear.

Cho, K., van Merriënboer, B., Bahdanau, D., and Bengio, Y. (2014b). On the properties of neural machine translation: encoder-decoder approaches. In Eighth Workshop on Syntax, Semantics and Structure in Statistical Translation. to appear.

Devlin, J., Zbib, R., Huang, Z., Lamar, T., Schwartz, R., and Makhoul, J. (2014). Fast and robust neural network joint models for statistical machine translation. In Association for Computational Linguistics.

Forcada, M. L. and Ñeco, R. P. (1997). Recursive hetero-associative memories for translation. In J. Mira, R. Moreno-Díaz, and J. Cabestany, editors, Biological and Artificial Computation: From Neuroscience to Technology, volume 1240 of Lecture Notes in Computer Science, pages 453-462. Springer Berlin Heidelberg.

Goodfellow, I., Warde-Farley, D., Mirza, M., Courville, A., and Bengio, Y. (2013). Maxout networks. In Proceedings of The 30th International Conference on Machine Learning, pages 1319-1327.

Graves, A. (2012). Sequence transduction with recurrent neural networks. In Proceedings of the 29th International Conference on Machine Learning (ICML 2012).

Graves, A. (2013). Generating sequences with recurrent neural networks. arXiv:1308.0850 [cs.NE].

Graves, A., Jaitly, N., and Mohamed, A.-R. (2013). Hybrid speech recognition with deep bidirectional LSTM. In Automatic Speech Recognition and Understanding (ASRU), 2013 IEEE Workshop on, pages 273-278.

Hermann, K. and Blunsom, P. (2014). Multilingual distributed representations without word alignment. In Proceedings of the Second International Conference on Learning Representations (ICLR 2014).

Hochreiter, S. (1991). Untersuchungen zu dynamischen neuronalen Netzen. Diploma thesis, Institut für Informatik, Lehrstuhl Prof. Brauer, Technische Universität München.

Hochreiter, S. and Schmidhuber, J. (1997). Long short-term memory. Neural Computation, 9(8), 1735-1780.

Kalchbrenner, N. and Blunsom, P. (2013). Recurrent continuous translation models. In Proceedings of the ACL Conference on Empirical Methods in Natural Language Processing (EMNLP), pages 1700-1709. Association for Computational Linguistics.

Koehn, P. (2010). Statistical Machine Translation. Cambridge University Press, New York, NY, USA.

Koehn, P., Och, F. J., and Marcu, D. (2003). Statistical phrase-based translation. In Proceedings of the 2003 Conference of the North American Chapter of the Association for Computational Linguistics on Human Language Technology - Volume 1, NAACL ’03, pages 48-54, Stroudsburg, PA, USA. Association for Computational Linguistics.

Pascanu, R., Mikolov, T., and Bengio, Y. (2013a). On the difficulty of training recurrent neural networks. In ICML’2013.

Pascanu, R., Mikolov, T., and Bengio, Y. (2013b). On the difficulty of training recurrent neural networks. In Proceedings of the 30th International Conference on Machine Learning (ICML 2013).

Pascanu, R., Gulcehre, C., Cho, K., and Bengio, Y. (2014). How to construct deep recurrent neural networks. In Proceedings of the Second International Conference on Learning Representations (ICLR 2014).

Pouget-Abadie, J., Bahdanau, D., van Merriënboer, B., Cho, K., and Bengio, Y. (2014). Overcoming the curse of sentence length for neural machine translation using automatic segmentation. In Eighth Workshop on Syntax, Semantics and Structure in Statistical Translation. to appear.

Schuster, M. and Paliwal, K. K. (1997). Bidirectional recurrent neural networks. Signal Processing, IEEE Transactions on, 45(11), 2673-2681.

Schwenk, H. (2012). Continuous space translation models for phrase-based statistical machine translation. In M. Kay and C. Boitet, editors, Proceedings of the 24th International Conference on Computational Linguistics (COLIN), pages 1071-1080. Indian Institute of Technology Bombay.

Schwenk, H., Dchelotte, D., and Gauvain, J.-L. (2006). Continuous space language models for statistical machine translation. In Proceedings of the COLING/ACL on Main conference poster sessions, pages 723-730. Association for Computational Linguistics.

Sutskever, I., Vinyals, O., and Le, Q. (2014). Sequence to sequence learning with neural networks. In Advances in Neural Information Processing Systems (NIPS 2014).

Zeiler, M. D. (2012). ADADELTA: An adaptive learning rate method. arXiv:1212.5701 [cs.LG].

A 模型的架构

A.1 架构的选择

在第3 节中提出的方案是一个通用框架,其中人们可以自由定义例如递归神经网络(RNN)的激活函数f 和对齐模型a。 在这里,我们描述了我们为本文中的实验所做的选择。

A.1.1 循环神经网络

对于RNN的激活函数f,我们使用最近由Cho et al. 2014a等人提出的门控隐藏单元。 门控隐藏单元是传统简单单元的替代方式,例如元素级别的tanh。 这个门控单元与Hochreiter and Schmidhuber (1997)早些时候提出的长期短期记忆(LSTM)单元类似,都能更好的建模和学习长期依赖性。 这是通过在展开的RNN中具有导数乘积接近1的计算路径来实现的。 这些路径允许梯度容易地向后流动而不会由于消失效应而受到太多损失(Hochreiter, 1991; Bengio et al., 1994; Pascanu et al., 2013a)。 因此,可以使用LSTM单元来代替这里描述的门控隐藏单元,正如Sutskever et al. 2014在类似的背景下所做的那样。

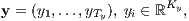

使用n 个门控隐藏单元8 的新状态si 通过以下等式计算:

si = f(si-1,yi-1,ci) = (1 - zi) ∘ si-1 + zi ∘ i , i , |

i由以下计算

i由以下计算

i = tanh i = tanh![(W e(yi-1)+ U [ri ∘si-1]+ Cci)](search83x.png) , , |

Update 门zi 允许每个隐藏单元维持它的之前的激活,reset 门ri 控制应该重新设置之前的状态的大小和什么信息。 我们通过下面的等式计算它们

| zi | = σ , , | ||

| ri | = σ  , , |

是一个logistic sigmoid函数。

是一个logistic sigmoid函数。

在解码器的每一步,我们计算输出概率(等式4)为一个多层函数(Pascanu et al., 2014)。 我们使用一个单隐层的maxout 单元(Goodfellow et al., 2013),并用一个softmax 函数规范化输出概率(每个单词一个)(参见等式6)。

A.1.2 对齐模型

对齐模型的设计应该考虑到模型需要对每个长度为Tx 和Ty 的句子对求值Tx ×Ty 次。 为了减少计算量,我们使用单层多层感知器

a(si-1,hj) = va⊤tanh , , |

A2 模型的详细描述

A.2.1 编码器

在本节中,我们将详细描述实验中用到的我们提出的模型(RNNsearch)的架构(请参见4-5节)。 从这里开始,为了提高可读性我们省略了所有偏差项。

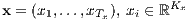

该模型接受一个源语句作为输入,源语句由1-of-K编码的词向量组成

并输出一个翻译后的语句,翻译后的语句同样由1-of-K编码的词向量组成

其中Kx 和Ky 分别为源语言和目标语言的词汇大小。 Tx 和Ty 分别表示源语句和目标语句的长度。

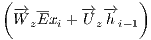

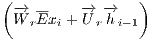

首先,计算双向递归神经网络(BiRNN)的前向状态:

i = i = |  |

i = i = | tanh![( [ ])

-→W Exi + -→U -→r i ∘-→hi-1](search97x.png) | ||

i = i = | σ | ||

i = i = | σ . . |

,

, z,

z, r ∈ ℝn×m,

r ∈ ℝn×m,  ,

, z,

z, r ∈ ℝn×n 为权重矩阵。 m 和n 分别为词嵌入的维度和隐藏单元的数目。

σ(⋅) 通常是一个logistic sigmoid 函数。

后向状态的计算(

r ∈ ℝn×n 为权重矩阵。 m 和n 分别为词嵌入的维度和隐藏单元的数目。

σ(⋅) 通常是一个logistic sigmoid 函数。

后向状态的计算( 1,

1, ,

, Tx) 类似。 我们在前向和后向RNN之间共享词嵌入矩阵E,这与权重矩阵不同。

我们将前向和后向状态合并得到注解(h1,h2,

Tx) 类似。 我们在前向和后向RNN之间共享词嵌入矩阵E,这与权重矩阵不同。

我们将前向和后向状态合并得到注解(h1,h2, ,hTx),其中

,hTx),其中

h i =  | (7) |

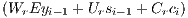

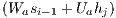

A.2.2 解码器

给定编码器的注解,解码器的隐藏状态si 通过下面的等式计算

| si = | (1 - zi) ∘ si-1 + zi ∘ i , i , |

i = i = | tanh![(W Eyi-1 + U [ri ∘si-1]+ Cci)](search119x.png) | ||

| z i = | σ | ||

| r i = | σ |

, where

Ws ∈ ℝn×n。

, where

Ws ∈ ℝn×n。

上下文向量ci 在每个步骤都通过对齐模型重新计算:

| ci = | ∑ j=1Tx αijhj , |

| αij = |  | ||

| eij = | va⊤tanh , , |

Tx,这个模型将变成RNN编码器—解码器(Cho et al., 2014a)。

根据解码器状态si-1、上下文ci 和上一个单词yi-1 ,我们定义目标单词yi 的概率为

Tx,这个模型将变成RNN编码器—解码器(Cho et al., 2014a)。

根据解码器状态si-1、上下文ci 和上一个单词yi-1 ,我们定义目标单词yi 的概率为

| p(yi|si ,yi-1,ci) ∝ | exp , , |

| t i = |  j=1,…,l⊤ j=1,…,l⊤ |

i,k 是向量

i,k 是向量 i 的第k 个元素,它的计算通过

i 的第k 个元素,它的计算通过

i = i = | Uosi-1 + V oEyi-1 + Coci. |

A.2.3 模型的大小

对于本文中使用的所有模型,隐藏层n的大小为1000,词嵌入的维度m为620,深度输出l的隐藏层大小为是500。 对齐模型n'中隐藏单元的数量为1000。

| Model | Updates (×105) | Epochs | Hours | GPU | Train NLL | Dev. NLL |

| RNNenc-30 | 8.46 | 6.4 | 109 | TITAN BLACK | 28.1 | 53.0 |

| RNNenc-50 | 6.00 | 4.5 | 108 | Quadro K-6000 | 44.0 | 43.6 |

| RNNsearch-30 | 4.71 | 3.6 | 113 | TITAN BLACK | 26.7 | 47.2 |

| RNNsearch-50 | 2.88 | 2.2 | 111 | Quadro K-6000 | 40.7 | 38.1 |

| RNNsearch-50 ⋆ | 6.67 | 5.0 | 252 | Quadro K-6000 | 36.7 | 35.2 |

B 训练过程

B.1 参数的初始化

我们初始话循环权重矩阵U, Uz ,Ur , ,

, z ,

z , r ,

r , ,

, z 和

z 和 r 为随机正交矩阵。 对于Wa 和Ua,我们通过从均值为0且方差为0.0012的高斯分布采样初始化它们。 Va的所有元素和所有的偏差向量被初始化为零。 任何其它权重矩阵通过从均值为0和方差为0.012的高斯分布采样来初始化。

r 为随机正交矩阵。 对于Wa 和Ua,我们通过从均值为0且方差为0.0012的高斯分布采样初始化它们。 Va的所有元素和所有的偏差向量被初始化为零。 任何其它权重矩阵通过从均值为0和方差为0.012的高斯分布采样来初始化。

B.2 训练

我们使用随机梯度下降(SGD)算法。 Adadelta (Zeiler, 2012) 用来自动适应每个参数的学习速率(ϵ = 10-6 and ρ = 0.95)。 当损失函数的梯度的L2规范化形式大于预定义的阈值1时,我们每次显式地规范化它到这个阈值(Pascanu et al., 2013b)。 每个SGD更新方向用80个句子的小批计算。

在每次更新时,我们的实现需要的时间与minibatch中最长句子的长度成比例。 因此,为了尽量减少计算浪费,在每20次更新之前,我们检索1600个句子对,根据长度对它们进行排序并将它们分成20个小的批次。 训练数据在训练前被洗乱一次,并按照这种方式顺序进行。

在表2中,我们列出了与训练实验中使用的所有模型有关的统计数据。

C 长语句的翻译

| Source | An admitting privilege is the right of a doctor to admit a patient to a hospital or a medical centre to carry out a diagnosis or a procedure, based on his status as a health care worker at a hospital. |

| Reference | Le privilège d’admission est le droit d’un médecin, en vertu de son statut de membre soignant d’un hôpital, d’admettre un patient dans un hôpital ou un centre médical afin d’y délivrer un diagnostic ou un traitement. |

| RNNenc-50 | Un privilège d’admission est le droit d’un médecin de reconnaître un patient à l’hôpital ou un centre médical d’un diagnostic ou de prendre un diagnostic en fonction de son étatde santé。 |

| RNNsearch-50 | Un privilège d’admission est le droit d’un médecin d’admettre un patient à un hôpital ou un centre médical pour effectuer un diagnostic ou une procédure, selon son statut de travailleur des soins de santé àl'hôpital。 |

| Google Translate | Un privilège admettre est le droit d’un médecin d’admettre un patient dans un hôpital ou un centre médical pour effectuer un diagnostic ou une procédure, fondée sur sa situation en tant que travailleur de soins de santé dans un hôpital。 |

| Source | This kind of experience is part of Disney’s efforts to ”extend the lifetime of its series and build new relationships with audiences via digital platforms that are becoming ever more important,” he added. |

| Reference | Ce type d’expérience entre dans le cadre des efforts de Disney pour ”étendre la durée de vie de ses séries et construire de nouvelles relations avec son public grâce àdes plateformes num ériquesqui sont de plus en plus importantes“,a-t-il ajouté。 |

| RNNenc-50 | Ce type d’expérience fait partie des initiatives du Disney pour ”prolonger la durée de vie de ses nouvelles et de développer des liens avec les lecteurs numériques qui deviennent plus complexes. |

| RNNsearch-50 | Ce genre d’expérience fait partie des efforts de Disney pour ”prolonger la durée de vie de ses séries et créer de nouvelles relations avec des publics via des plateformes numériques de plus en plus importantes“,a-t-il ajouté。 |

| Google Translate | Ce genre d’expérience fait partie des efforts de Disney à “étendre la durée de vie de sa série et construire de nouvelles relations avec le public par le biais des plates-formes numériques qui deviennent de plus en plus important“,at-il ajouté。 |

| Source | In a press conference on Thursday, Mr Blair stated that there was nothing in this video that might constitute a ”reasonable motive” that could lead to criminal charges being brought against the mayor. |

| Reference | En conférence de presse, jeudi, M. Blair a affirmé qu’il n’y avait rien dans cette vidéo qui puisse constituer des ”motifs raisonnables” pouvant mener au dépôt d’une accusation criminelle contre le maire. |

| RNNenc-50 | Lors de la conférence de presse de jeudi, M. Blair a dit qu’il n’y avait rien dans cette vidéo qui pourrait constituer une ”motivation raisonnable” pouvant entraîner des accusations criminelles portéescontre le maire。 |

| RNNsearch-50 | Lors d’une conférence de presse jeudi, M. Blair a déclaré qu’il n’y avait rien dans cette vidéo qui pourrait constituer un ”motif raisonnable” qui pourrait conduire à des accusations criminelles contre le maire。 |

| Google Translate | Lors d’une conférence de presse jeudi, M. Blair a déclaré qu’il n’y avait rien dans cette vido qui pourrait constituer un“motif raisonnable”qui pourrait mener à des accusations criminelles portes contre le maire. |